大数据Flume怎样安装

1、日志采集Flume安装

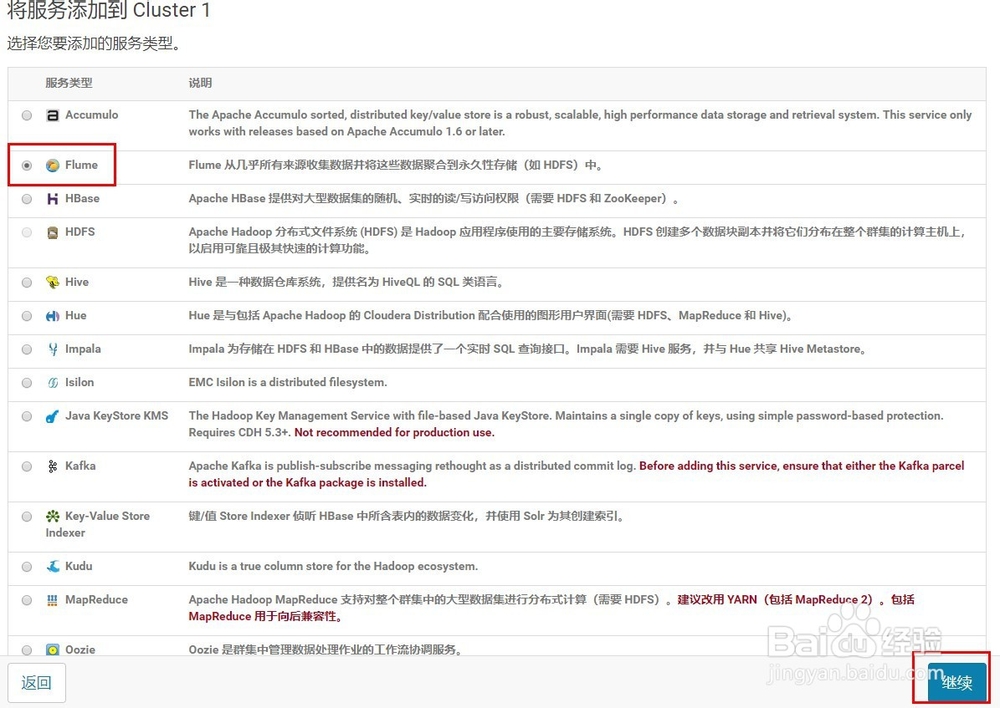

1)添加服务

2、2)选择Flume,点击继续

3、3)选择节点

4、4)完成

5、日志采集Flume配置

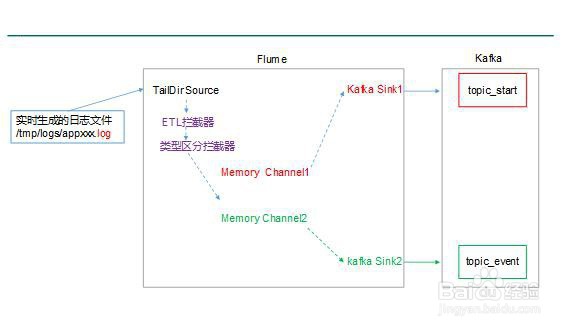

1)Flume配置分析

6、Flume直接读log日志的数据,log日志的格式是app-yyyy-mm-dd.log。

2)Flume的具体配置如下:

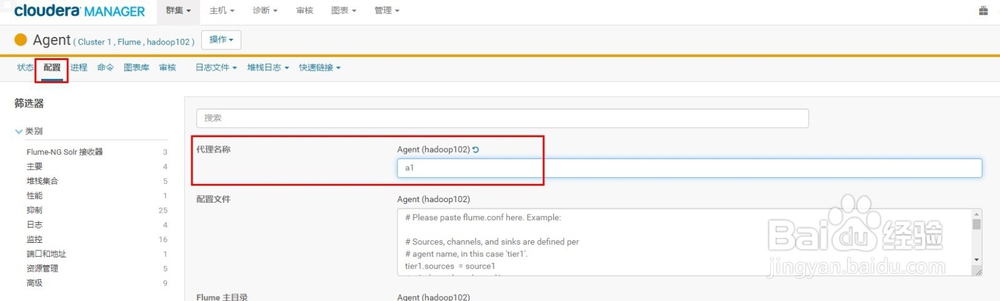

(1)在CM管理页面hadoop102上Flume的配置中找到代理名称改为a1

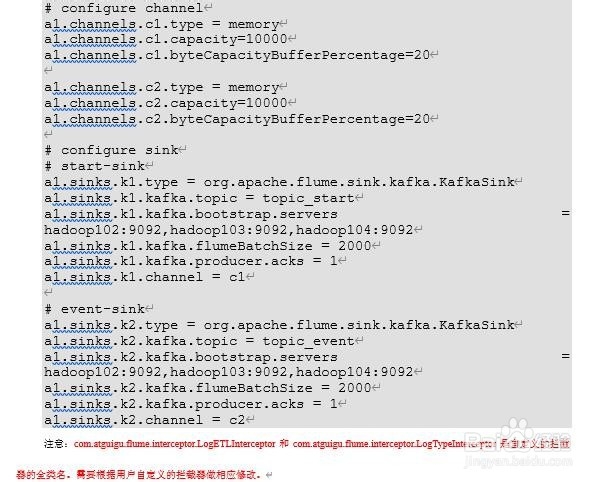

7、(2)在配置文件如下内容(flume-kafka)

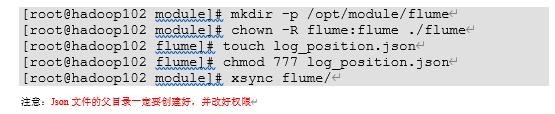

8、(3)修改/opt/module/flume/log_position.json的读写权限

9、Flume拦截器

本项目中自定义了两个拦截器,分别是:ETL拦截器、日志类型区分拦截器。

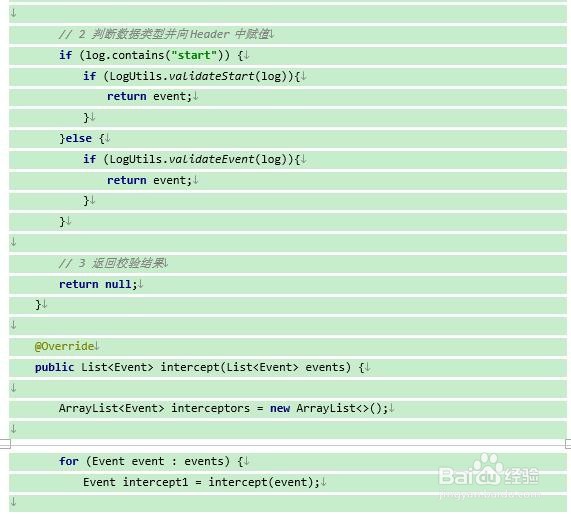

ETL拦截器主要用于,过滤时间戳不合法和Json数据不完整的日志

日志类型区分拦截器主要用于,将启动日志和事件日志区分开来,方便发往Kafka的不同Topic。

1)创建Maven工程flume-interceptor

10、2)创建包名:com.atguigu.flume.interceptor

11、3)在pom.xml文件中添加如下配置

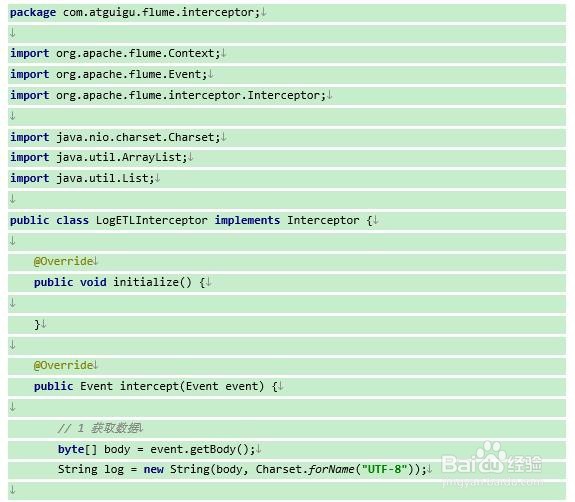

12、4)在com.atguigu.flume.interceptor包下创建LogETLInterceptor类名

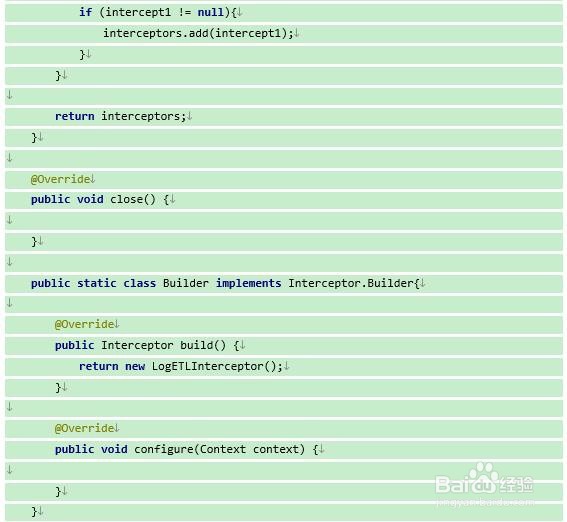

Flume ETL拦截器LogETLInterceptor

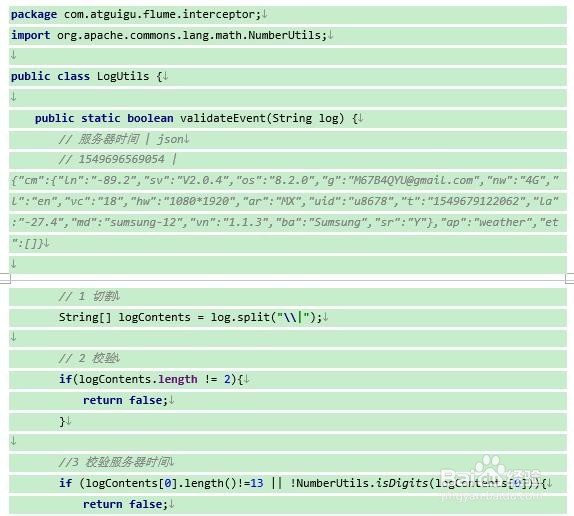

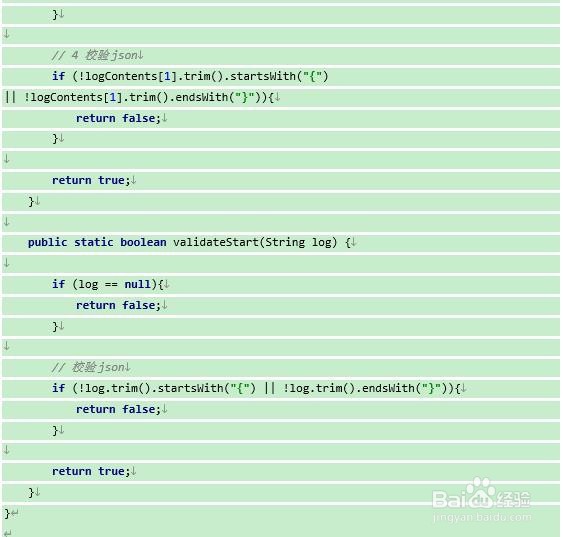

13、5)Flume日志过滤工具类

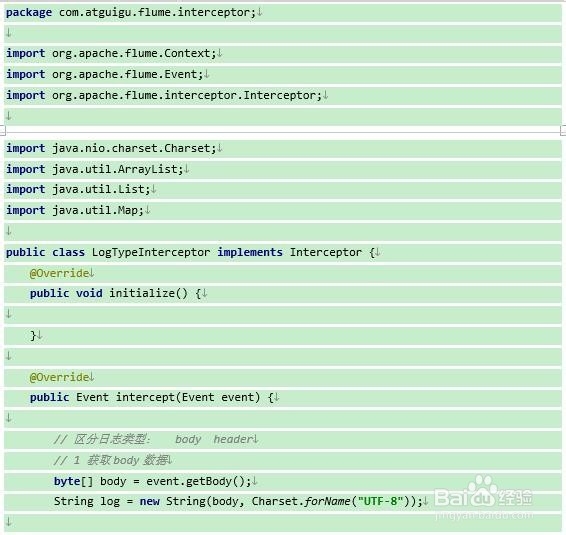

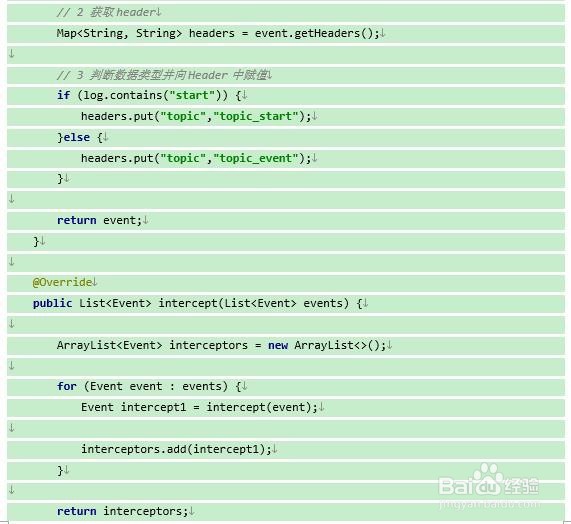

14、6)Flume日志类型区分拦截器LogTypeInterceptor

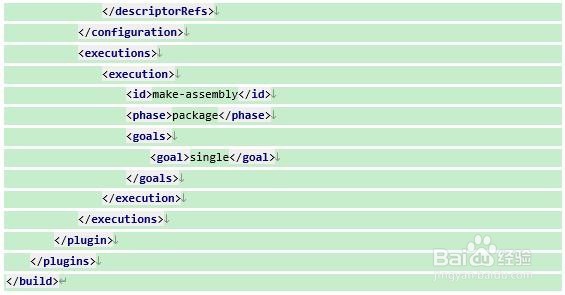

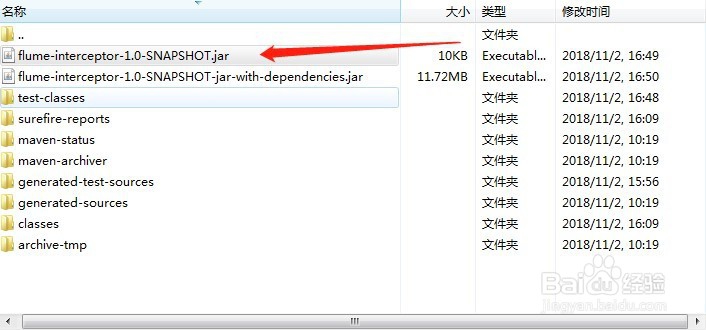

15、7)打包

拦截器打包之后,只需要单独包,不需要将依赖的包上传。打包之后要放入flume的lib文件夹下面。

16、注意:为什么不需要依赖包?因为依赖包在flume的lib目录下面已经存在了。

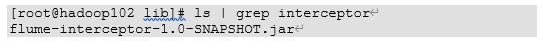

8)采用root用户将flume-interceptor-1.0-SNAPSHOT.jar包放入到hadoop102的/opt/cloudera/parcels/CDH-5.12.1-1.cdh5.12.1.p0.3/lib/flume-ng/lib/文件夹下面。

17、9)分发Flume到hadoop103

18、10)启动Flume,并查看日志